deekseek-r1本地部署指南极简版

![]() 写在前面

写在前面

最近,deepseek ai发布了一个超强开源版本的大模型,效果接近于Chat GPT o1-mini,并且提供了支持本地部署的版本,本教程旨在让读者学会本地部署,后续的应用落地,随缘更新❤️。

![]() 环境

环境

本人在本地部署了两个版本的deepseek-r1,分别为8b和14b版本。其中8b可以流畅推理,14b版本推理速度会慢一点,平均等待时间10-20秒。

环境为

CPU:amd 3100

GPU:RTX 3060 8G

MEMORY:16G

SYSTEM: win11

![]() 部署

部署

![]() 1.安装 ollama

1.安装 ollama

首先进入 ollama 官网 https://ollama.com/

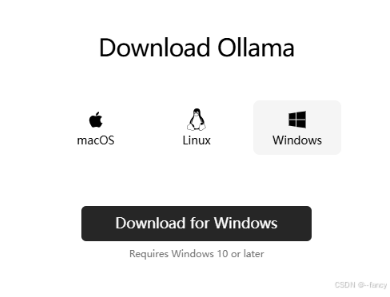

然后点击download,选择本地电脑对应的版本

下载后进行安装。

注意:安装时默认使用C盘,确保你的C盘有足够多的空间可以安装 ollama 及后续的大模型,

建议C盘空间 ≥ 12 G

安装后在电脑开始页面启动 ollama,然后查看任务栏,有 ollama 图标意味着 ollama已经启动。

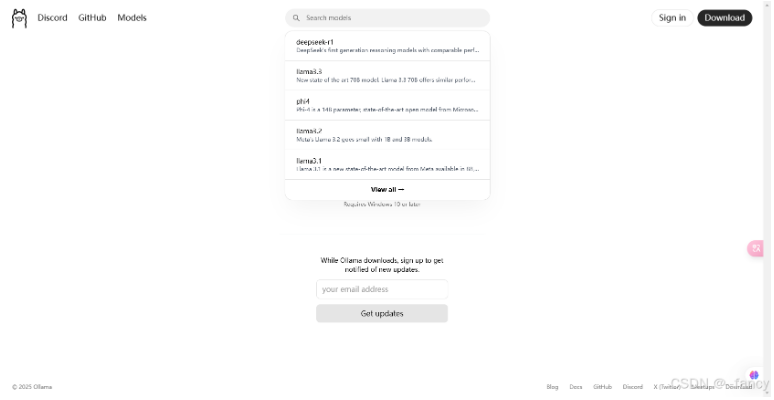

我们回到 ollama 官网,在搜索栏搜索 deepseek-r1

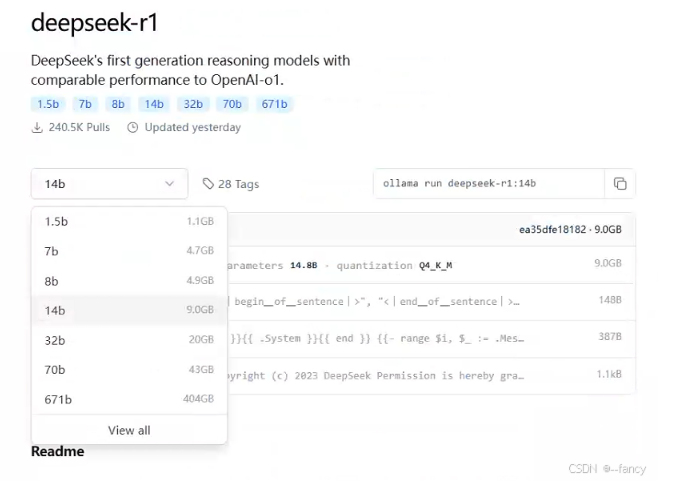

选择适合自己的版本,注意右侧的GB代表磁盘容量,确保C盘有足够的磁盘容量。

如果你的电脑和我配置差不多可以尝试8b,

拥有12G以上的显存使用14b版本应该可以流畅运行,

更多的参数量,例如32b建议使用3090或4090。

![]() 2.部署 deepseek-r1

2.部署 deepseek-r1

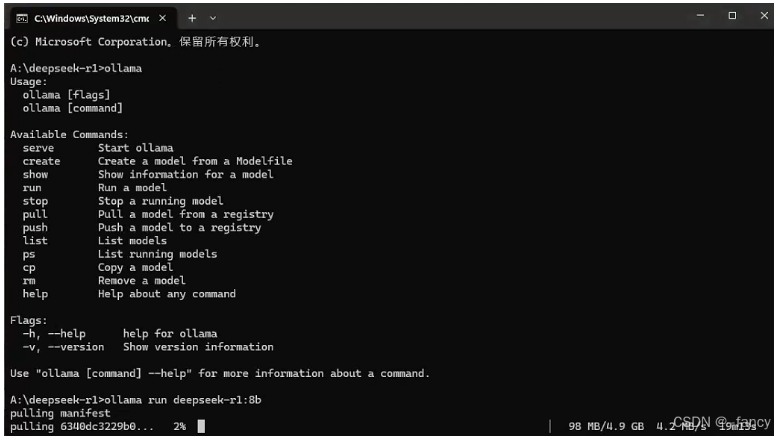

使用下面命令进行安装,8b代表选择8b的版本

ollama run deepseek-r1:8b1

随后打开任务管理器(记得用管理员),然后输入命令进行部署,本地会下载对应的模型。

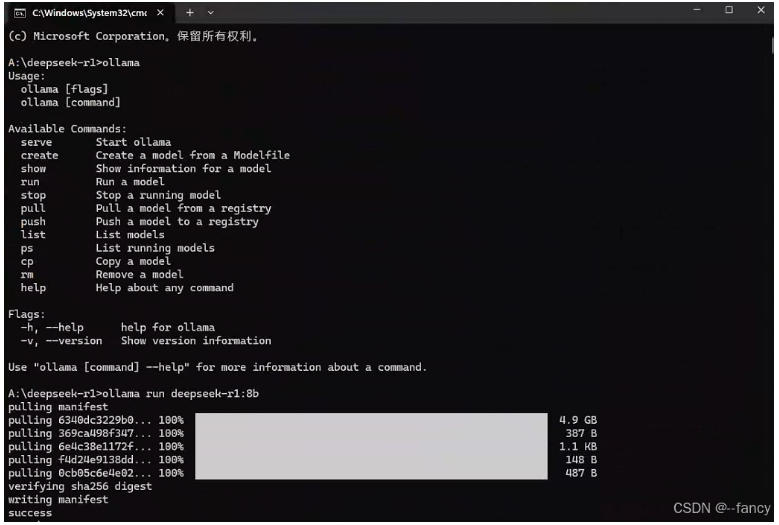

出现下面情况代表安装完成,当然可能会出现超时问题,重新运行上面部署代码即可

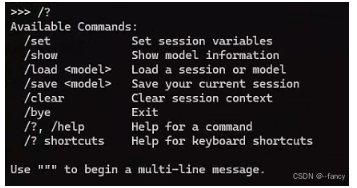

然后使用/?或/help进行测试。

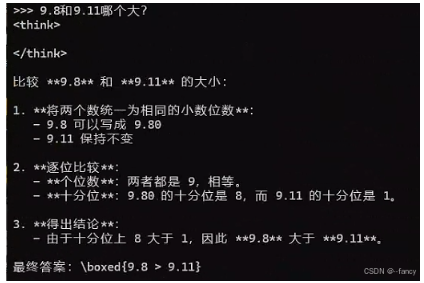

最后展示下效果

这就是deepseek-r1本地部署的极简教程,如果需要使用网页等方式进行展示对话也是可以的,这些就是后面的内容了,敬请期待❤️。

最后附带一个案例,展示deepseek-r1的推理水平。