LLaVA-OneVision-1.5 - 免费开源的多模态模型,高性能多模态理解

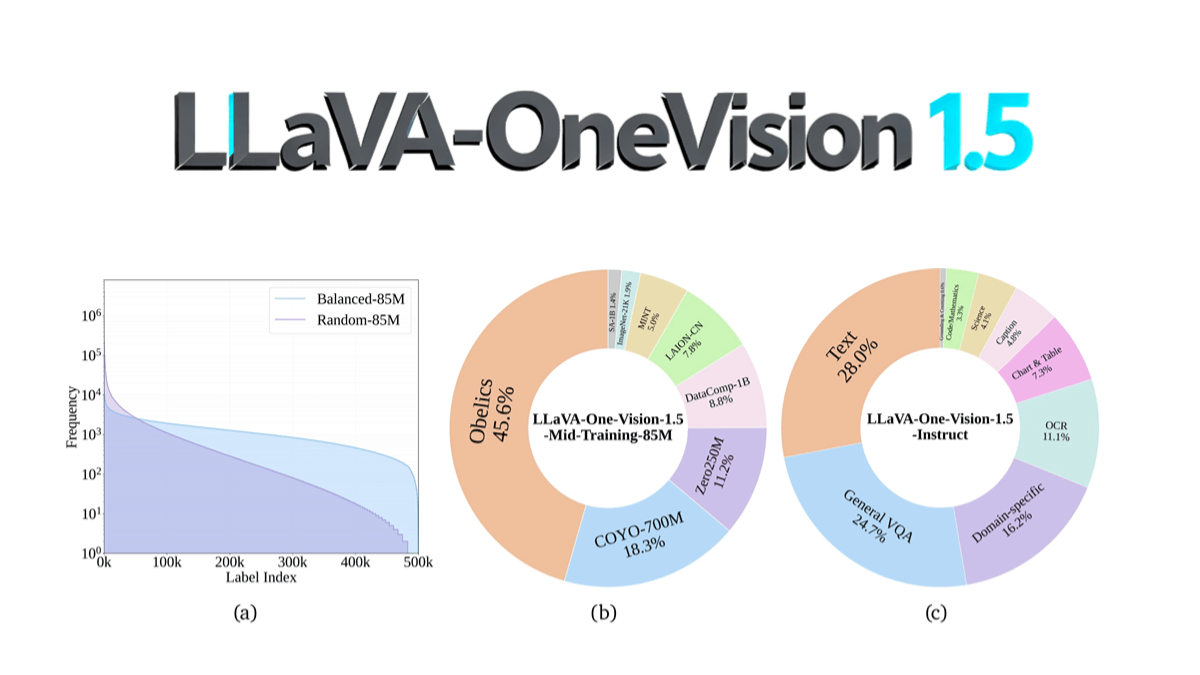

LLaVA-OneVision-1.5是EvolvingLMMS-Lab团队开源的多模态模型,采用8B参数规模,通过紧凑三阶段训练流程(语言-图像对齐、概念均衡与知识注入、指令微调)在128张A800 GPU上4天完成预训练,总成本约1.6万美元。其核心创新包括RICE-ViT视觉编码器支持原生分辨率与区域级细粒度语义建模,以及通过"概念均衡"策略优化数据利用率。在OCR、文档理解等任务上性能超越Qwen2.5-VL,并首次实现全流程开源(含数据、训练工具链、评测脚本),显著降低多模态模型复现门槛。模型代码已发布在GitHub,支持社区低成本复现与二次开发。